曉談數據工程 數據存儲、數據處理與存儲支持服務解析

數據工程作為現代數據驅動決策的核心支撐,其三大支柱——數據存儲、數據處理以及存儲支持服務,構成了企業數據生命周期的骨架。本文旨在深入探討這三者的內在邏輯、技術演進與協同實踐,為構建高效、可靠的數據基礎設施提供參考。

一、數據存儲:數據工程的基石

數據存儲是數據工程的起點與歸宿,其核心任務是為海量、多源、異構的數據提供持久化存放的物理或邏輯空間。隨著數據規模與形態的演變,存儲技術也經歷了從傳統關系型數據庫到分布式、云原生存儲的躍遷。

1. 存儲介質與架構演進

從硬盤、SSD到內存與持久內存,存儲介質的性能提升為數據訪問速度帶來了革命性變化。架構層面,集中式存儲逐漸向分布式存儲(如HDFS、Ceph、對象存儲)演進,以滿足可擴展性、容錯性與成本控制的需求。云存儲服務(如AWS S3、Azure Blob Storage)的普及,進一步降低了存儲管理的復雜度。

2. 數據模型與存儲格式

根據數據使用場景,存儲模型需靈活適配。結構化數據常采用關系型數據庫(如MySQL、PostgreSQL)或數倉(如Snowflake、BigQuery);半結構化與非結構化數據則傾向于NoSQL數據庫(如MongoDB、Cassandra)或對象存儲。存儲格式的選擇(如Parquet、ORC、Avro)直接影響數據處理效率,列式存儲因優秀的壓縮與查詢性能,已成為分析型場景的主流。

二、數據處理:從原始數據到價值的轉化器

數據處理是將原始數據轉化為可用信息與知識的關鍵環節,涵蓋數據清洗、轉換、集成、分析與建模等步驟。其核心目標是提升數據質量、挖掘數據價值,并支撐上層應用。

1. 批處理與流處理雙軌并行

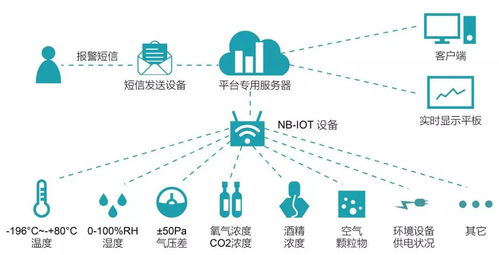

批處理(如Apache Spark、Flink批模式)適用于對時效性要求較低的大規模歷史數據分析,而流處理(如Apache Kafka Streams、Flink流模式)則應對實時數據流,滿足監控、預警等即時決策需求。現代數據平臺常采用Lambda或Kappa架構,實現批流一體融合處理。

2. 數據處理框架與生態

開源生態蓬勃發展,Hadoop、Spark、Flink等框架提供了強大的分布式計算能力。云原生數據處理服務(如AWS Glue、Google Dataflow)通過托管服務簡化了運維。數據處理正朝著自動化(AutoML)、智能化(AI增強數據質量)方向發展,減少人工干預成本。

三、存儲支持服務:數據高效流動的保障

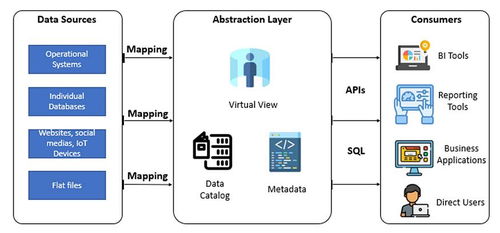

存儲支持服務是連接數據存儲與處理的“粘合劑”,確保數據在存儲、計算、應用間高效、安全、可靠地流動。它涵蓋數據管理、元數據管理、數據安全與治理等關鍵支撐能力。

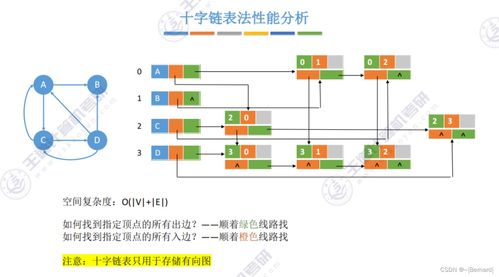

1. 數據管理與元數據服務

數據目錄(如Apache Atlas、DataHub)通過元數據管理,實現數據資產的發現、血緣追蹤與影響分析,提升數據可發現性與可信度。數據生命周期管理(如分層存儲、自動歸檔)則優化存儲成本與性能平衡。

2. 數據安全與治理

在數據合規要求日益嚴格的背景下,存儲支持服務必須集成加密(靜態/傳輸中)、訪問控制(RBAC、ABAC)、審計日志等功能。數據治理框架(如數據質量監控、主數據管理)確保數據在整個生命周期中的一致性、準確性與合規性,為數據價值釋放保駕護航。

協同演進,構建韌性數據架構

數據存儲、數據處理與存儲支持服務并非孤立存在,而是相互依存、協同演進的有機整體。在云原生與AI驅動的趨勢下,未來的數據工程將更加強調自動化、智能化與一體化。企業需根據自身業務規模、技術棧與成本考量,靈活選擇與整合這三層能力,構建彈性、高效且安全的數據架構,從而在數據洪流中穩健航行,真正實現數據驅動的創新與增長。

如若轉載,請注明出處:http://www.zjgqydk.cn/product/54.html

更新時間:2026-01-08 07:00:13